Weka DM – Le package « Python Weka Wrapper 3 »

Le debugger de VS Code – Python

Positron – L'EDI pour R « et » Python

Orange DM - Courbe ROC et Courbe de Gain

Orange DM - Clustering – CAH des variables

Orange DM - Clustering – CAH des individus

Orange DM - Cartes de Kohonen (SOM)

Orange DM - Clustering avec les K-Means

Orange DM - Comparaison de modèles

Orange DM - Arbres de décision

Règles d'association avec « arules » pour R

Sequential pattern mining - PySpark

Règles d'association avec PySpark

Stacking de classifieurs - mlxtend

Règles d'association - mlxtend/Python

Manipulation des DataFrames PySpark

Apply parallélisé pour DataFrame Pandas

Embarrassingly parallel problem sous R

Manip. des données "data.table" (pour R)

Manip. des données "datatable" (Python)

DuckDB + Pandas - Combinaison gagnante

Pandas vs. Polars - Performances comparées

Estimation et test statistiques

Parallélisation des traitements avec Joblib (Python)

Parallélisation Numba pour OneVsRestClassifier (Python)

Python rapide avec Taichi (vs. Numba)

Vectorisation des calculs – Numpy, Numba, Xarray (Python)

Intégration de code C dans Python avec Cython

Intégration de code C++ dans un projet R avec Rcpp

Combiner R et Python via Reticulate

Few-shot classification en NLP (spaCy / classy-classification)

Image to text et traduction (Hugging Face / Transformers)

Sentiment Analysis en NLP (Hugging Face / Transformers)

Zero-shot classification en NLP (Hugging Face / Transformers)

Deep Learning sous R avec le package torch

R et Python - Performances comparées

Knime Interactive R Statistics Integration

Auto-encodeur avec PyTorch (Python)

Transfer Learning avec PyTorch (torchvision / Python)

Modèles pré-entraînés pour le classement (PyTorch / Python)

ConvNet (CNN) avec tensorflow / keras (Python)

ConvNet (CNN) avec PyTorch (torchvision / Python)

Classement multiclasse avec PyTorch (Python)

Classement binaire avec PyTorch (Python)

Formulaire interactif dans un notebook (ipywigdets / Python)

Clustering – Déploiement Web App (streamlit / Python)

Pipeline – FunctionTransformer (scikit-learn / Python)

Pipeline – Paramétrage (scikit-learn / Python)

Microsoft Copilot... est mon ami

Pipeline - ColumnTransformer (scikit-learn / Python)

LibreOffice Calc - Filtres et Tableaux croisés

Macros Python pour LibreOffice Calc (2)

Fonctions personnalisées Python pour LibreOffice Calc

Macros Python pour LibreOffice Calc (1)

Requêtes SQL sur DataFrame Pandas (pandasql / Python)

Dockerisation (BD [SQLite] + Web App Python [gradio])

NLP - Catégorisation de doc. avec "fasttext" (Python)

NLP - Reconnaissance de la langue (fasttext / Python)

Déploiement des classifieurs avec R Shiny + Docker

Suivi avec MLFLOW TRACKING (PyCaret / Python)

Déploiement facile via GRADIO (PyCaret / Python)

Déploiement via STREAMLIT + DOCKER (Pycaret)

Déploiement via une API REST (PyCaret / Python)

Machine learning avec tidymodels pour R

Text Mining (NLP) - Le package spaCy pour Python

La méthode DISMIX (Python / scientisttools)

La méthode DISQUAL (Python / scientisttools)

PROC CANDISC avec "scientisttools" (Python)

Analyse discriminante - Projet Etudiant Python

PROC DISCRIMIN et STEPDISC (scientisttools / Python)

Analyse discriminante PLS (Python / scikit-learn)

Régression et classement - Equivalences (Python)

Clustering - Gap statistic - Nombre de groupes

ACP avec scientisttools - Nombre de composantes

Arbres de décision- Post-élagage avec R / rpart

Post-élagage des arbres - Python / Scikit-learn

Clustering tree avec Python / Scikit-Learn

Multidimensional Scaling avec Scientisttools

Analyses factorielles avec "scientisttools"

Clustering - Détection des communautés (igraph)

Segmentation d'image - K-Means (OpenCV vs. Scipy)

KMeans - Accélérer Scikit-learn / Python

Clustering de documents textuels avec PyCaret

Clustering des modalités de var. qualitatives (ACM)

ACP - Effet taille, indice KMO/MSA, corr. partielles

ACP + Rotation Quartimax et Clustering de variables

ACP sous Python avec statsmodels - Rotation Varimax

ACM sous Python avec fanalysis

AFC sous Python avec fanalysis

ACP sous Python avec fanalysis

Clustering flou - La méthode Fuzzy C-Means (Python)

K-Means - Pipeline et Déploiement (sklearn+fanalysis)

Tandem Clustering - Classif. sur données mixtes (R)

Clustering de modalités de variables quali (Python)

Clustering de Variables Quantitatives (Python)

Clustering Mixte - Carte de Kohonen + CAH (R)

Clustering Mixte - K-Means + CAH (R)

Clustering - Mesures éval. des partitions (sklearn)

Notebooks Jupyter (Python) avec VS Code

Environnement conda - Jupyter notebook et VSCode

Introduction au clustering - K-means sous Knime

Clustering - K-Means - Tanagra + Excel

Tanagra - AFDM #2 - Var. illustratives, indiv. supp.

Tanagra - AFDM #1 - Analyse fact. des données mixtes

Tanagra - ACM #2 - Var. illustratives, indiv. supp.

Tanagra - ACM #1 - Analyse fact. des corres. multiples

Tanagra - AFC #2 - Modalités lignes (colonnes) supp.

Tanagra - AFC #1 - Analyse factorielle des corresp.

Tanagra - ACP #6 - Tandem clustering : ACP + CAH

Tanagra - ACP #5 - VARCLUS, clustering de variables

Tanagra - ACP #4 - Rotation varimax, corr. partielles

Tanagra - ACP #3 - Var illus., indiv. supplémentaires

Tanagra - ACP #2 - Paramètres optionnels

Tanagra - ACP #1 - Calculs et post-traitements Excel

Explicabilité des modèles - Slides

Cours Delphi / Pascal - Travaux dirigés

(Vidéo) Représentation pré-entraînée GloVe avec Keras

(Vidéo) La couche Embedding de Keras en NLP

(Vidéo) Natural Language Processing avec Keras

(Vidéo) Modèle pré-entraîné Word2Vec avec Gensim

(Vidéo) Word2Vec / Doc2Vec avec Gensim - Python

(Vidéo) Topic Modeling avec Gensim / Python

(Vidéo) Word Embedding – L'algorithme Word2Vec

(Vidéo) StandardScaler et descente de gradient

(Vidéo) Topic Modeling avec Knime

(Vidéo) Text mining avec Knime

(Vidéo) Text mining avec quanteda sous R

(Vidéo) Text mining avec tidytext sous R

(Vidéo) Subdivision train-test avec scikit-learn

(Vidéo) Machine learning avec PyCaret

(Vidéo) Arbres de décision avec scikit-learn

(Vidéo) Ridge, Lasso – Optim. des hyperparamètres

Régression Logistique – Machine Learning

(Vidéo) Excel – Filtres, tableaux croisés

(Vidéo) Cross-validation, leave-one-out

(Vidéo) SAS sous Python avec SASPy

(Vidéo) Extension Intel(R) pour scikit-learn

(Vidéo) Perceptron avec TensorFlow / Keras (Python)

(Vidéo) Anaconda Python - Environnements

(Vidéo) Régression logistique avec Python / scikit-learn

(Vidéo) Régression logistique avec Knime

(Vidéo) La Proc Logistic de SAS

(Vidéo) Régression logistique pas-à-pas

(Vidéo) Régression avec la "proc reg" de SAS

(Vidéo) Régression linéaire avec Excel + Tanagra

(Vidéo) Programmation parallèle sous R

(Vidéo) Programmation MapReduce sous R

(Vidéo) Parallel Machine Learning avec Dask

(Vidéo) Gestion des DataFrame avec Dask (Python)

(Vidéo) Programmation parallèle avec Dask

(Vidéo) Cost-sensitive learning

Econométrie par Régis Bourbonnais

(Vidéo) Model Explainability par H2O

(Vidéo) Outils pour l'interprétation des modèles

(Vidéo) Python – AutoML de Scikit-Learn

(Vidéo) Python – AutoML de H2O

(Vidéo) Python - Le package Yellowbrick

(Vidéo) Stratégies pour classes déséquilibrées

(Vidéo) Extraction des règles d'association

(Vidéo) Subdivision apprentissage-test avec R

(Vidéo) Sélection forward en ADL

(Vidéo) Classification sur données pré-classées

(Vidéo) Arbres sur très grandes bases avec R

(Vidéo) Arbres de décision avec R

(Vidéo) La méthode des K-Means sous R et Python

(Vidéo) Déploiement de Pipeline Python

(Vidéo) Régression logistique multinomiale avec keras

(Vidéo) Régression logistique sous R avec Keras

(Vidéo) La régression logistique de scikit-learn

Titre : (Vidéo) Sélection rapide de variables

(Vidéo) Classifieurs linéaires

(Vidéo) Induction de règles prédictives

(Vidéo) Description des modèles avec PMML

(Vidéo) Manipulation des DataFrames "pandas"

(Vidéo) Analyse discriminante sous Python

(Vidéo) Analyse discriminante sous SAS

(Vidéo) ADL sous R avec "discriminR"

(Vidéo) Recodage des explicatives qualitatives en ADL

(Vidéo) Exportation des modèles prédictifs

(Vidéo) Conversion d'un Notebook Python avec Pandoc

(Vidéo) Modélisation, évaluation, déploiement

(Vidéo) Subdivision train-test pour les comparaisons

Réduction de dimension - La méthode GLRM

Pratique des Méthodes Factorielles avec Python

Pratique de l'Analyse Discriminante Linéaire

Dépendances des variables qualitatives - Version 2.1

Analyse Discriminante Linéaire sous R

Analyse Discriminante Linéaire sous Python

Régression Logistique sous Python

Régression Logistique -- TD 4.b

Régression Logistique -- TD 4.a

Régression Logistique -- TD 2.b

Régression Logistique -- TD 2.a

Détection des anomalies sous Python

Arbres de décision avec Scikit-Learn

Détection des anomalies - Diapos

Implémentation du Naive Bayes sous R

Deep learning : l'algorithme Word2Vec

Deep learning avec PyTorch sous Python

Auto-encodeur avec Keras sous Python

Deep learning : les auto-encodeurs

Discrétisation supervisée rapide

Ateliers Master SISE : logiciel SAS

Python Machine Learning avec Orange

Machine Learning - Outils pour l'enseignement

Performances des boucles sous R

Réseaux de neurones convolutifs sous Knime

Deep Learning avec Keras sous Knime

Économétrie - Projet Open Data

Régression ZIP sous R et Python

Régression de Poisson - Diapos

Économétrie - TD 6 - Évaluation

Économétrie - TD 5 - Régression sous Python

Économétrie - TD 4 - Régression sous R (II)

Économétrie - TD 3 - Régression sous R (I)

Économétrie - TD 2 - Régression multiple

Économétrie - TD 1.b - Régression simple

Économétrie - TD 1.a - Corrélation

Python - Détection de communautés avec MDS

Multidimensional scaling sous R

Positionnement multidimensionnel - Diapos

Programmer efficacement sous Python

Graphique de dépendance partielle - R et Python

Interpréter un classement en analyse prédictive

Python - Machine learning avec mlxtend

Programmer efficacement sous R

Importance des variables dans les modèles

Règles d'association sous Python

R et Python, performances comparées

Machine Learning avec H2O (Python)

Packages Python pour le Deep Learning

Packages R pour le Deep Learning

Deep learning : perceptrons simples et multicouches

Ateliers Master SISE : outils de la Dataviz

Master SISE - Remise à niveau - SQL

Pipeline sous Python - La méthode DISQUAL

Analyses factorielles sous Python avec fanalysis

Régressions ridge et elasticnet sous R

Descente de gradient stochastique sous Python

Deep Learning - Tensorflow et Keras sous R

Deep Learning avec Tensorflow et Keras (Python)

Requêtes avec jointures sous R

Régression linéaire sous Excel

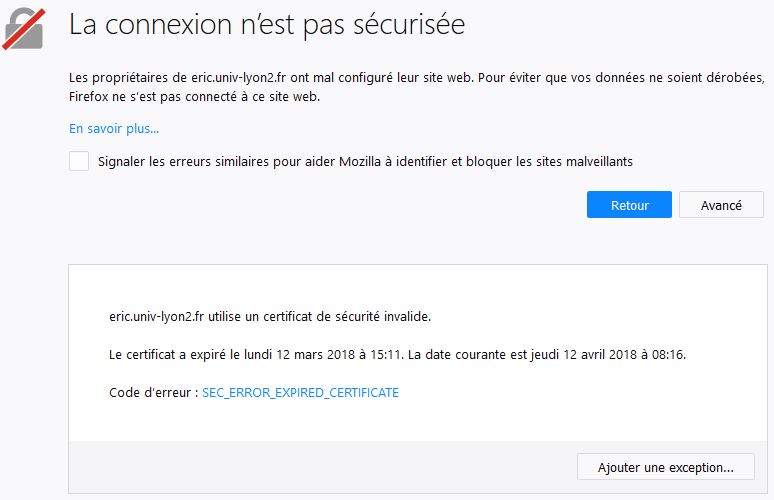

Panne partielle du serveur Eric

Stratégies d'échantillonnage pour la modélisation

Master SISE - Remise à niveau - Python Statistique

R ou Python, il faut choisir ?

Ressources partagées - Apprentissage supervisé

Ateliers : Outils de la Data Science

Comprendre la taille d'effet (effect size)

De la statistique à la data science

Probabilités et quantiles sous Excel, R et Python

Détection de communautés sous Python

Détection de communautés - Diapos

Python : Manipulations des données avec Pandas

Filtrage collaboratif et recommandations - Diapos

Les expression régulières sous R

Fouille d'opinions et analyse des sentiments - Diapos

Text mining : catégorisation de SMS sous Python

Excel avancé - Cours et exercices corrigés

Text mining : topic model - Diapos

Text mining : la catégorisation de textes - Diapos

Text mining : la matrice documents termes - Diapos

Introduction au text mining - Diapos

Etude des logiciels de data science

Clustering : la méthode TwoStep Cluster

Clustering : algorithme des k-médoïdes - Diapos

Clustering : méthode des centres mobiles - Diapos

Clustering : caractérisation des classes - Diapos

Master SISE - Remise à niveau - Clustering

Master SISE - Remise à niveau - Analyse prédictive

Master SISE - Remise à niveau - Inférence statistique

Master SISE - Remise à niveau - Analyses factorielles

Les cartes auto-organisatrices de Kohonen - Diapos

Master SISE - Remise à niveau - Introduction à R

Classification ascendante hiérarchique - Diapos

ANOVA à un et deux facteurs - Diapos

Master SISE - Remise à niveau - Statistique Descriptive

Master SISE - Programme de remise à niveau - Excel

Les add-ins Tanagra et Sipina pour Excel 2016

Programmation Python sous Spark avec PySpark

Programmation R sous Spark avec SparkR

SVM : Support Vector Machine avec R et Python

SVM : Support Vector Machine - Diapos

Gradient boosting avec R et Python

Mining of Massive Datasets (2nd Edition)

Classification automatique sous Python

Building Machine Learning Systems

Data Science : fondamentaux et études de cas

Random Forest et Boosting avec R et Python

Bagging, Random Forest, Boosting - Diapos

Classification automatique sous R

Python - Econométrie avec StatsModels

Python - Machine learning avec scikit-learn

Python - Statistiques avec SciPy

Python - Les matrices avec NumPy

Python - Les vecteurs avec NumPy

Python - La distribution Anaconda

Les fichiers sous Python - Diapos

Les classes sous Python - Diapos

Collection d'objets sous Python - Diapos

Fonctions et modules sous Python - Diapos

Introduction à Python - Diapos

Programmation MapReduce sous R - Diapos

Big Data et Machine Learning...

Extraction des règles d'association - Diapos

Pratique de la régression - Version 2.1

Reconnaissance faciale et détection de l’âge

Prédicteurs catégoriels en Rég. Logistique

Analyse de corrélation - Version 1.1

Validation croisée, Bootstrap - Diapos

Arbres de classification - Théorie et pratique

Decision Trees for Analytics...

Méthodologie statistique pour l'analyse prédictive

Règles de décision prédictives - Diapos

Data Mining with Decision Trees

Introduction aux arbres de décision - Diapos

Clustering de variables qualitatives - Diapos

Induction par arbre avec WinIDAMS

La discrétisation des variables quantitatives (slides)

Nouveaux arbres interactifs dans SPAD 8

Nouveau site web pour Sipina (FR)

L'add-in Sipina pour Excel 2007 et 2010

SQL Server Data Mining Add-Ins

L'add-in Real Statistics pour Excel

Régression linéaire pour le classement

Analyse discriminante et régression linéaire

Text mining avec Knime et RapidMiner

Classification de variables qualitatives

Classification automatique sur données mixtes

Scilab et R - Performances comparées

Programmation à partir d'objets statistiques sous R

Manipulation des vecteurs sous R

Programmation modulaire sous R

Analyse Factorielle de Données Mixtes - Diapos

Analyse des correspondances multiples - Diapos

Analyse en composantes principales - Diapos

Analyse des correspondances discriminante - Diapos

Analyse factorielle des correspondances - Diapos

Programmation parallèle sous R

Multithreading équilibré pour la discriminante

Multithreading pour l'analyse discriminante

Associations dans la distribution SIPINA

Paramétrer le perceptron multicouche

Analyse des correspondances multiples - Outils

Analyse des correspondances discriminante

Analyse des correspondances - Comparaisons

Analyse en facteurs principaux

Analyse factorielle de données mixtes

Manipulation des données avec R

Analyse discriminante linéaire - Comparaisons

ACP sur corrélations partielles (suite)

ACP avec Tanagra - Nouveaux outils

ACP avec R - Détection du nombre d'axes

ACP sous R - Indice KMO et test de Bartlett

La librairie LIBCVM (Core Vector Machine)

Introduction à R - Arbre de décision

Introduction à R - Régression logistique

Tinn-R, un éditeur de code pour R

Vérification des données manquantes - Tanagra

Régression logistique sur les grandes bases

Arbres de décision sur les grandes bases (suite)

Arbres sur les " très" grandes bases (suite)

Connexion entre R et Excel via RExcel

L'add-in Tanagra pour Excel 2010 - 64 bits

Données manquantes en déploiement

Données manquantes - Régression logistique

Extraction des itemsets fréquents

Tanagra add-on pour OpenOffice Calc 3.3

Pratique de la Régression Linéaire (version 2)

Régression avec le logiciel LazStats (OpenStat)

REGRESS dans la distribution SIPINA

Régression linéaire simple et multiple

Classifieur Bayesien Naïf - Diaporama

Régression - Déploiement de modèles

Régression linéaire - Lecture des résultats

Régression Linéaire Multiple - Diaporama

Régression Linéaire Simple - Diaporama

Introduction à l'Econométrie - Diaporama

Analyse factorielle discriminante - Diaporama

ACP avec FactoMineR et dynGraph

Outils pour le développement d'applications

Régles d'association - Données transactionnelles

Arbres de décision sur les grands fichiers (mise à jour)

Multithreading pour les arbres de décision

Création de rapports avec Tanagra

Bayesien naïf pour prédicteurs continus

Nouvelle interface pour RapidMiner 5.0

Le format PMML pour le déploiement de modèles

Connexion Sipina/Excel via OLE [XL-SIPINA]

L'add-in Tanagra pour Excel 2007 et 2010

Filtrage des prédicteurs discrets

Data Mining sous R - Le package rattle

Déploiement des modèles prédictifs avec R

Traitement des très grands fichiers avec R

Tanagra dans La revue Modulad (2005)

Tanagra - Présentation à EGC'2005

Sipina - Présentation de l'ancienne version 2.5

Traitement des classes déséquilibrées

Tanagra et autres logiciels gratuits

Le classifieur Bayesien Naïf revisité

Discrétisation - Comparaison de logiciels

"Wrapper" pour la sélection de variables (suite)

Induction de règles floues avec Knime

Arbres de décision interactifs avec SPAD

Induction de Règles Prédictives

Sipina – Traitement des très grands fichiers

Sipina - Echantillonnage dans les arbres

Sipina - Traitement des données manquantes

Evaluation des classifieurs - Quelques courbes

Diagnostic de la régression logistique

Etude des dépendances - Variables qualitatives

Probabilités et Statistique - Note de cours

Tests de conformité à la loi normale

Pratique de la Régression Linéaire Multiple

Comparaison de populations - Tests paramétriques

Pratique de la régression logistique

Statistiques descriptives (suite)

Stratégie « wrapper » pour la sélection de variables

Analyse factorielle des correspondances avec R

Analyse des Corresponsances Multiples avec R

Installation des packages sous R

Diagnostic de la régression avec R

Analyse en Composantes Principales avec R

Connexion Open Office Calc sous Linux

Règles d'Association Prédictives

Utiliser et paramétrer A PRIORI MR

Mesures d'intérêt des règles dans A PRIORI MR

Comparaison des performances sous Linux

Coûts de mauvais classement en apprentissage supervisé

Règles d’association – Comparaison de logiciels

Validation croisée - Comparaison de logiciels (suite)

Classification automatique - Déploiement de modèles

K-Means – Comparaison de logiciels

Traitement de gros volumes – CAH Mixte

Régression logistique - Comparaison de logiciels

SVM - Comparaison de logiciels

Traitement de gros volumes – Comparaison de logiciels

Tanagra : Spécifications, Développement, Promotion

La méthode CART dans Tanagra et R (package rpart)

Comparaison des dispersions pour K échantillons indépendants

Tests de comparaison pour 2 échantillons appariés

Test de Kruskal-Wallis et comparaisons multiples

Tests non paramétriques de comparaison de 2 populations. Modèle de localisation.

Comparaison de populations – Tests non paramétriques

Comparaison de populations - Tests paramétriques multivariés

Comparaison de populations - Tests paramétriques univariés

Régression PLS – Comparaison de logiciels

Détection (univariée) des points aberrants

Analyse Discriminante PLS – Etude comparative

Programmer un composant dans TANAGRA

Interpréter la « valeur test »

Régression logistique ordinale

Analyse discriminante linéaire

Analyse de variance de Friedman

Tests d’adéquation à la loi normale

Analyse de variance et comparaison de variances

Mesures d’association – Variables ordinales

Mesures d’association – Variables nominales

Coefficient de corrélation linéaire

Régression PLS – Sélection du nombre d’axes

Tanagra : un logiciel open source

Règles d’association - Orange, Tanagra et Weka

Règles d’association avec Apriori PT

Règles d’association « supervisées »

A PRIORI sur les bases transactionnelles

Règles d’association – Algorithme A PRIORI

Réseaux de neurones avec SIPINA, TANAGRA et WEKA

Apprentissage-test avec ORANGE, TANAGRA et WEKA

Arbres de décision avec ORANGE, TANAGRA et WEKA

Courbe ROC avec ORANGE, TANAGRA et WEKA

Logiciels gratuits pour l’enseignement (déc.2005)

Points aberrants et influents dans la régression

Statistiques descriptives comparatives

Travailler sur les corrélations partielles

K-Means sur variables qualitatives

Régression logistique multinomiale

Stepdisc – Analyse discriminante

Listes de décision (vs. arbres de décision)

Support vector machine (SVM) multi-classes

Construction de variables avec NIPALS

Echantillonnage dans les arbres de décision

Analyse discriminante sur axes principaux

Validation croisée, bootstrap, leave one out

Comparaison de classifieurs – Validation croisée

Courbe ROC pour la comparaison de classifieurs

Statistiques descriptives avec SIPINA

Scoring avec la régression logistique

Ciblage marketing (scoring) – Coil challenge

Déploiement de modèles avec Tanagra

Sélection de variables – Bayesien naïf

Traitement des grands fichiers

Sauver et charger des parties du diagramme

Copier coller dans le diagramme

Importer un fichier Weka dans Tanagra

Discrétisation contextuelle – La méthode MDLPC

Importer un fichier Weka dans Sipina

Description de l’interface SIPINA

Déploiement d'un arbre de décision avec SIPINA

Classification automatique - Algorithme EM

Analyse discriminante descriptive - Vins de Bordeaux

Sélection forward - Crime dataset

Régression - Expliquer la consommation des véhicules

CAH Mixte - Le fichier Iris de Fisher

CART - Détermination de la taille de l'arbre

Arbres de décision - ID3 sur Breast Cancer

AFC - Association médias et professions

ACP - Description de véhicules

Arbres interactifs - Sipina et Orange

Apprentissage - test avec Sipina

Analyse interactive avec Sipina

Importation fichier XLS (Excel) [Mode natif]

Importation fichier XLS (Excel) [Macro complémentaire]

Ricco Rakotomalala

Isolation Forest

2026-01-14 (Tag:6lmdp57sRsk)

Machine Learning. Data Science. Détection des outliers. Isolation forest une méthode de détection des anomalies, des points atypiques. Elle isole les observations en créant une multitude d'arbres aléatoirement. Les anomalies, étant rares et différentes, sont généralement isolées plus rapidement dans des feuilles survenant dans les parties hautes de l'arbre. Le fonctionnement de l'approche est décrit sur un jeu de données réaliste.

Document (pdf): Isolation Forest

Données et programme : Programme R et Données

Weka Data Mining – Le package « Python Weka Wrapper 3 »

2025-11-10 (Tag:45V2A_kc2vs)

Machine Learning. Data Science. Présentation du package « python-weka-wrapper3 », qui nous donne accès aux fonctionnalités de Weka, aux très nombreux algorithmes de machine learning notamment, dans un programme Python. Création d’un environnement dédié (conda). Puis description des tâches usuelles d’une démarche d’analyse prédictive : importation des données (fichier « arff », une sorte de fichier CSV qui intègre un dictionnaire des variables), partition en échantillons d’apprentissage et de test, entraînement du modèle (SVM avec un noyau linéaire), évaluation (accuracy, matrice de confusion) ; indentification du meilleur paramétrage avec l’outil « GridSearchCV » de Weka ; comparaison des performances de plusieurs algorithmes (SVM linéaire, arbre de décision, régression logistique, K-NN).

Lien vidéo: https://www.youtube.com/watch?v=45V2A_kc2vs

Notebook + Fichier YAML : Programme - Notebook - Données

Weka Data Mining – Analyse prédictive

2025-11-01 (Tag:nmXB1W83XuE)

Machine learning. Data Science. Présentation du logiciel Weka dans le cadre d’une analyse prédictive. Importation des données (CSV), partition en apprentissage-test, modélisation (régression logistique), évaluation en test (matrice de confusion, rappel, précision, accuracy, taux d’erreur), différentes courbes (précision-rappel, roc, lift cumulé), récupération des classes prédites.

Lien vidéo: https://www.youtube.com/watch?v=nmXB1W83XuE

Notebook + Fichier YAML : Programme - Notebook - Données

Le debugger de VS Code – Programmation Python

2025-10-31 (Tag:FqTiVdkRNS4)

Machine learning. Data Science. Présentation du debugger de VS Code pour le débogage des programmes en Python. L’outil permet de suivre à la trace le (bon) déroulement de notre code. Plusieurs aspects sont détaillés dans cette vidéo : le placement de points d’arrêts pour interrompre le programme à des endroits spécifiques, l’exécution pas à pas qui permet de suivre le cheminement des instructions, l’inspection de l’état des variables (création, valeurs prises) à chaque étape. Le débugger permet de remplacer avantageusement la pratique souvent répandue qui consiste à disséminer plus ou moins judicieusement des print() dans nos programmes.

Lien vidéo: https://www.youtube.com/watch?v=FqTiVdkRNS4

Notebook + Fichier YAML : Programme - Notebook - Données

Le debugger de RStudio – Programmation R

2025-10-30 (Tag:K-KSxHE1t6U)

Machine learning. Data Science. Présentation du debugger de RStudio. L’outil permet de suivre à la trace le (bon) déroulement d’un programme R que nous développons. Plusieurs aspects sont détaillés dans cette vidéo : le placement de points d’arrêts pour interrompre le programme à des endroits spécifiques, l’exécution pas à pas qui permet de suivre le cheminement des instructions, l’inspection de l’état des variables (création, valeurs prises) à chaque étape. Le débugger permet de remplacer avantageusement la pratique souvent répandue qui consiste à disséminer plus ou moins judicieusement des print() dans nos programmes.

Lien vidéo: https://www.youtube.com/watch?v=K-KSxHE1t6U

Notebook + Fichier YAML : Programme - Notebook - Données

Le profiler de RStudio – Programmation R

2025-10-30 (Tag:q8N13RyFslc)

Machine learning. Data Science. Utilisation de l’outil de profilage de RStudio (« profiler ») pour l’optimisation du temps d’exécution d’un programme en langage R. Identification des goulots d’étranglements, les différentes solutions pour améliorer la rapidité des traitements. Exemple illustratif avec l’implémentation d’un leave-one-out avec l’analyse discriminante (lda) du package MASS. Le profiler a permis de mettre en évidence les parties critiques du code. Nous obtenons des gains substantiels en les retravaillant. Ici il s’agissait simplement de modifier le prototype de la fonction appelée pour l’apprentissage, associer à un choix approprié des structures de données.

Lien vidéo: https://www.youtube.com/watch?v=q8N13RyFslc

Notebook + Fichier YAML : Programme - Notebook - Données

Positron – L'EDI Data Science pour R « et » Python

2025-10-19 (Tag:5keUBMSoWxU)

Positron est un EDI (environnement de développement intégré) pour la data science. Il est édité par les auteurs de RStudio (Posit PBC). Il permet de développer de manière indifférenciée [dans le même environnement de travail] des projets de data science / machine learning en langage R et langage Python, avec des fonctionnalités étendues (cf. « Features » du site web). Dans cette vidéo, nous explorons de manière très succincte la possibilité d’éditer des notebook (.ipynb) pour R et pour Python (environnement Conda). Pour avoir un peu plus de recul, j’ai demandé à ChatGPT de faire un petit comparatif avec des outils de référence tels que RStudio et VSCode.

Lien vidéo: https://www.youtube.com/watch?v=5keUBMSoWxU

Notebook + Fichier YAML : Programme - Notebook - Données

Orange Data Mining – Analyse des correspondances multiples (ACM)

2025-10-16 (Tag:62NJToD3O5k)

Machine learning. Analyse des données. Réalisation d’une ACM (ou AFCM – Analyse [factorielle] des correspondances multiples) sous Orange Data Mining. Obtention des coordonnées des modalités des variables dans l’espace factoriel. Déduction des coordonnées des individus (qui n’est pas fourni nativement) via un script Python. Le widget « Python Script » permet d’élargir considérablement les possibilités de l’outil. Les résultats sont mis en miroir avec ceux du package « FactoMineR » pour R. En effet, Orange Data Mining s’appuie sur une approche numérique différente de notre mode de calcul usuel.

Lien vidéo: https://www.youtube.com/watch?v=62NJToD3O5k

Notebook + Fichier YAML : Programme - Notebook - Données

Orange Data Mining – Analyse en composantes principales (ACP)

2025-10-13 (Tag:x6ySioivcaw)

Machine learning. Analyse des données. Réalisation d’une ACP (analyse en composantes principales) sous Orange Data Mining. Screeplot, choix du nombre de composantes. Projection des individus dans les plans factoriels. Mise en avant des options d’illustration pour mieux situer le positionnement relatif des points (couleurs, taille,…). Elaboration du cercle des corrélations (qui n’existe pas nativement). Encore une fois les fonctionnalités interactives du logiciel font merveille pour une exploration dynamique (ludique même) des données.

Lien vidéo: https://www.youtube.com/watch?v=x6ySioivcaw

Notebook + Fichier YAML : Programme - Notebook - Données

Orange Data Mining – Courbe ROC et Courbe de Gain

2025-10-11 (Tag:FUeOP9Tbj_0)

Machine learning. Sous Orange Data Mining, construction des courbes ROC (receiver operating characteristic) et de gain (lift cumulé) en analyse prédictive. Deux courbes d’aspects très similaires, mais qui ne sont pas construites de la même manière, qui n’ont pas la même finalité, et qui n’ont pas la même lecture. La première est plutôt un outil d’évaluation, associée notamment au critère AUC (aire sous la courbe) (bien qu’elle se prête à d’autres usages aussi), la seconde est un outil opérationnel utilisé dans le ciblage (souvent en marketing, mais dans tout domaine où il y a un arbitrage à réaliser dans une démarche de ciblage). La mise en œuvre sous Orange est très facile, y compris lorsque l’on souhaite comparer les performances de différents algorithmes.

Lien vidéo: https://www.youtube.com/watch?v=FUeOP9Tbj_0

Notebook + Fichier YAML : Programme - Notebook - Données

Orange Data Mining – Grille de score

2025-10-09 (Tag:4PVpYoKfNr0)

Machine learning. Construction d’un modèle prédictif sous la forme d’une grille de score avec le logiciel Orange Data Mining. Lien entre les coefficients d’une régression logistique (ou tout classifieur pouvant s’exprimer sous la forme d’une combinaison linéaire des descripteurs) et les « points » d’une grille d’affectation. Orange introduit de surcroît la sélection de variable, le recodage automatique, la possibilité de définir le nombre de critère à introduire dans grille et l’amplitude des valeurs. Le système de points est explicite et lisible, mais il s’agit bien d’un modèle prédictif dont on peut apprécier les performances sur un échantillon test.

Lien vidéo: https://www.youtube.com/watch?v=4PVpYoKfNr0

Notebook + Fichier YAML : Programme - Notebook - Données

Orange Data Mining – Clustering – CAH des variables

2025-10-06 (Tag:Z7Wwcwts6MI)

Machine learning. Clustering de variables quantitatives via la CAH (classification ascendante hiérarchique) avec le logiciel Orange Data Mining. Définition de la distance entre variables basée sur le coefficient de corrélation de Pearson. Construction de la partition. Visualisation de la solution dans un plan « factoriel » défini à partir du positionnement multidimensionnel (MDS – multidimensional scaling). Visualisation dynamique de la solution à partir des modifications interactives de la sélection dans le dendrogramme. Extension des fonctionnalités avec l'introduction du composant Python Script dans le workflow.

Lien vidéo: https://www.youtube.com/watch?v=Z7Wwcwts6MI

Notebook + Fichier YAML : Programme - Notebook - Données

Orange Data Mining – Clustering – CAH des individus

2025-10-05 (Tag:sMLoMc2VZ-c)

Machine learning. Clustering. CAH (classification ascendante hiérarchique) [des individus] avec Orange Data Mining. Calcul des distances par paires, construction du dendrogramme, visualisation des groupes dans le premier plan factoriel. * Exploration dynamique avec modification interactive de la solution [nombre de groupes] et conséquences sur les positions des clusters dans le plan*. Identification des variables importantes dans la définition de la partition. Caractérisation des groupes via une représentation graphie (boxplot). Ici aussi, possibilité d’étude temps réel via la manipulation interactive du dendrogramme.

Lien vidéo: https://www.youtube.com/watch?v=sMLoMc2VZ-c

Notebook + Fichier YAML : Programme - Notebook - Données

Orange Data Mining – Cartes de Kohonen (SOM)

2025-10-01 (Tag:kPOzoUDvWWc)

Machine learning. Apprentissage non-supervisé. Implémentation des Cartes de Kohonen (SOM – Self Organizing Maps) sous Orange Data Mining. Paramétrage. Lecture interprétation des résultats à travers les représentations graphiques associées à la carte (variables actives et illustratives). L’approche combine les avantages d’une technique de réduction de dimension et de clustering (pré-clustering) puisque chaque nœud représente un sous-ensemble d’observations. Il est possible de réaliser une CAH (classification ascendante hiérarchique) via la matrice des distances déduite de la carte.

Lien vidéo: https://www.youtube.com/watch?v=kPOzoUDvWWc

Notebook + Fichier YAML : Programme - Notebook - Données

Orange Data Mining – Clustering avec les K-Means

2025-10-01 (Tag:kyJGRZGKVPs)

Machine learning. Clustering avec la méthode des K-Means. Importation et inspection des données, préparation, spécification du nombre de clusters, identification des variables impactantes, interprétation des résultats, statistiques descriptives et graphiques conditionnellement aux groupes d’appartenance.

Lien vidéo: https://www.youtube.com/watch?v=kyJGRZGKVPs

Notebook + Fichier YAML : Programme - Notebook - Données

Orange Data Mining - Comparaison de modèles prédictifs

2025-09-29 (Tag:FxGIT5sYAyo)

Machine Learning. Workflow (simple) pour la comparaison de modèles prédictifs sur un dataset (arbres de décision, random forest, régression logistique, SVM [avec différents noyaux]). Validation croisée. Choix de la métrique à utiliser. Création d’un rapport à partir des résultats. Elaboration du classifieur définitif sur la totalité des données, la régression logistique. Expertise des coefficients du modèle.

Lien vidéo: https://www.youtube.com/watch?v=FxGIT5sYAyo

Notebook + Fichier YAML : Programme - Notebook - Données

Orange Data Mining - Arbres de décision

2025-09-25 (Tag:FMkPBGtA_mg)

Machine Learning. Construction des arbres de décision avec le logiciel « Orange Data Mining ». Création d’un workflow. Importation des données (fichier CSV). Description statistique. Spécification et entraînement d’un arbre de décision. Fonctionnalité très intéressante, possibilité d’explorer interactivement les sous-populations associés aux sommets de l’arbre. Evaluation des performances, schémas holdout et validation croisée. Exploration interactive encore une fois des sous-ensembles associés aux différentes situations de la matrice de confusion.

Lien vidéo: https://www.youtube.com/watch?v=FMkPBGtA_mg

Notebook + Fichier YAML : Programme - Notebook - Données

Règles d’association avec « arules » pour R

2025-03-25 (Tag:DduPerQqVeo)

Extraction des itemsets fréquents et des règles d’association, méthodes utilisées entres autres dans les systèmes de recommandations, à partir de données tabulaires avec la librairie « arules » pour R. Organisation initiale du fichier (tableau individus x variables), typage des variables (en type « factor » de R), extraction et post-traitement des itemsets et des règles, notamment via leur transformation en structure data frame de R (filtrage, tri, etc., tout type de traitement qui peut s’appliquer à un data frame). Le tutoriel a été réalisé sous Google Colab avec le moteur d’exécution R.

Lien vidéo: https://www.youtube.com/watch?v=DduPerQqVeo

Notebook + Fichier YAML : Programme - Notebook - Données

Utiliser R avec Google Colab

2025-03-10 (Tag:PEKfz66ujvg)

Configurer Google Colab pour l’utilisation de l’interpréteur de langage R (Exécution / Modifier le type d'exécution). Création d’un notebook : chargement des packages, importation des données, saisies des commandes et affichage des résultats. Installation à la volée de packages additionnels.

Lien vidéo: https://www.youtube.com/watch?v=PEKfz66ujvg

Notebook + Fichier YAML : Programme - Notebook - Données

Sequential Pattern Mining avec PySpark (Spark / Python)

2025-03-06 (Tag:vdUBP_iQHX4)

Extraction des motifs séquentiels à l’aide de la librairie PySpark pour Python. La notion de motifs séquentiels, des groupes d’évènements ordonnés chronologiquement (ex. les contenus des paniers d’achats d’une personne au cours des différentes visites dans une boutique), le lien avec la recherche des itemsets fréquents et les règles d’association, l’introduction d’une dimension temporelle (chronologique surtout), le changement d’individu statistique (on passe de la transaction à la personne qui effectue une succession de transactions). La préparation spécifique des données essentielle au bon fonctionnement de l’algorithme PrefixSpan de PySpark. L’analyse des sorties, en particulier leur filtrage pour mettre en évidence les résultats qui nous intéressent.

Lien vidéo: https://www.youtube.com/watch?v=vdUBP_iQHX4

Notebook + Fichier YAML : Programme - Notebook - Données

Règles d’association avec PySpark (Spark / Python)

2025-03-06 (Tag:K_b2FkYDjpk)

Extraction des itemsets fréquents et des règles d’association à partir d’un fichier de transactions avec la librairie « PySpark » pour Python, utilisés notamment dans le contexte des systèmes de recommandation. Organisation initiale du fichier de données (paniers d’achats), transformation pour pouvoir le présenter à une version parallélisée de FPGrowth. Rôle important des paramètres « support min » et « confiance min » dans la génération des solutions. Post-filtrage des itemsets et des règles à partir de leurs caractéristiques (présence des produits, cardinal des itemsets, critères numériques …). Le format des itemsets et des règles (DataFrame PySpark) nous permet de manipuler à loisir les résultats.

Lien vidéo: https://www.youtube.com/watch?v=K_b2FkYDjpk

Notebook + Fichier YAML : Programme - Notebook - Données

Stacking de classifieurs avec « mlxtend – Python »

2025-03-04 (Tag:o-KdfNqebWk)

Stacking de modèles à l’aide la librairie « mlxtend » pour Python. L’idée est de produire un meta-classifieur pour associer des modèles élaborés à partir d’un échantillon d’apprentissage. Dans notre cas, nous utilisons une régression logistique, ce qui revient à déterminer la pondération la plus efficace dans le mécanisme de combinaison. Utiliser les données d’apprentissage pour ce second entraînement reviendrait à favoriser les modèles qui font du sur-apprentissage. « mlxtend » propose une approche basée sur la validation croisée pour lever cet écueil. La vidéo aborde de plus les outils de « mlxtend » pour l’évaluation des performances (0.632 et 0.632+ bootstrap) et la comparaison de modèles (5x2cv paired t-test et f-test) via des procédures de rééchantillonnage.

Lien vidéo: https://www.youtube.com/watch?v=o-KdfNqebWk

Notebook + Fichier YAML : Programme - Notebook - Données

Règles d’association avec « mlxtend – Python »

2025-03-03 (Tag:QBjJwwPBBXk)

Extraction des itemsets fréquents et des règles d’association à partir d’un fichier de transactions avec la librairie « mlxtend » pour Python, utilisés notamment dans le contexte des systèmes de recommandation. Organisation du fichier de données (paniers d’achats), transformation nécessaire en tableau de booléens avant la présentation aux algorithmes. Rôle important des paramètres « support min » et « confiance min » dans la génération des solutions. Post-filtrage des itemsets et des règles à partir de leurs caractéristiques (présence des produits, cardinal des itemsets, critères numériques …). Le format des itemsets et des règles (DataFrame Pandas) nous permet de manipuler à loisir les résultats.

Lien vidéo: https://www.youtube.com/watch?v=QBjJwwPBBXk

Notebook + Fichier YAML : Programme - Notebook - Données

Machine learning avec PySpark – Spark / MLlib

2025-02-02 (Tag:dhdw_HOaLcg)

Mise en oeuvre d’une méthode de machine learning (une régression logistique) de la librairie MLlib via l’API Python PySpark (3.5.4) pour Spark. Les fichiers d’apprentissage et de test se présentent au format CSV usuel (avec en-tête, séparateur de colonne « ; », variable cible codée en chaînes de caractères). Nous mettons l’accent sur la préparation des données, assez spécifique, cruciale pour le bon fonctionnement du dispositif. La vidéo décrit dans ses aspects les plus schématiques les étapes d’entraînement sur l’échantillon d’apprentissage, de prédiction et d’évaluation sur l’échantillon test. L’idée est de disposer d’un exemple simple facile à reproduire.

Lien vidéo: https://www.youtube.com/watch?v=dhdw_HOaLcg

Notebook + Fichier YAML : Programme - Notebook - Données

Manipulation des DataFrames PySpark (Spark / Python)

2025-01-31 (Tag:xyoIgxZSD0E)

Introduction à Spark SQL, un module du framework Spark pour la manipulation des données structurées, en particulier les DataFrames. Nous nous appuyons sur l’API PySpark, il permet d’interagir avec Spark via le langage de programmation Python. La configuration du dispositif est extrêmement simple : il suffit de créer un environnement (j’utilise conda) et d’y installer la librairie. L’accès au moteur de calcul est transparent pour nous. Notre code est valable que notre structure sous-jacente soit une machine locale ou un cluster de machines. Plusieurs étapes sont décrites dans la vidéo : création d’une session, chargement d’un fichier CSV, quelques filtrages et calculs statistiques (moyennes, croisement). Enfin, PySpark nous offre la possibilité de réaliser des requêtes rédigées en langage SQL.

Lien vidéo: https://www.youtube.com/watch?v=xyoIgxZSD0E

Notebook + Fichier YAML : Programme - Notebook - Données

Apply parallélisé pour DataFrame Pandas Python

2025-01-30 (Tag:t7K5fcomn8k)

Solutions de parallélisation de la fonction « apply » de Pandas qui applique séquentiellement une fonction sur des colonnes d’un DataFrame Pandas. Le cadre spécifique où les calculs sont indépendants d’une colonne à l’autre. La décomposition des traitements et la consolidation des résultats sont très simplifiées. La parallélisation est alors d’une simplicité désarmante (traduit étrangement en « embarrasingly parallel problem » en anglais). Etude des fonctions « apply » parallélisées des librairies « Modin » (avec le moteur "dask") et « Pandarallel ». Comparaison des temps de traitement sur une base benchmark. Les gains en durée d’exécution sont substantiels avec une modification négligeable du code.

Lien vidéo: https://www.youtube.com/watch?v=t7K5fcomn8k

Notebook + Fichier YAML : Programme - Notebook - Données

Embarrassingly parallel problem sous R

2025-01-19 (Tag:Vwx3wZ3gl_M)

Etude du concept de « embarrassingly parallel problem » sous R. Contrairement à ce que laisse entendre la terminologie, l’idée est de montrer qu’il est possible d’implémenter la parallélisation des calculs avec une simplicité désarmante dans certaines situations. C’est le cas notamment lorsqu’il s’agit de traiter indépendamment les uns des autres les éléments d’une structure. L’effort d’adaptation du code du séquentiel au parallèle est quasi-nul, avec à la clé des réductions de temps de traitements significatifs. Dans la vidéo, nous détaillons les différentes solutions possibles pour appliquer une fonction de transformation aux colonnes d’un data frame sous R. Les packages utilisés sont « parallel », « doParallel » et « foreach ».

Lien vidéo: https://www.youtube.com/watch?v=Vwx3wZ3gl_M

Notebook + Fichier YAML : Programme - Notebook - Données

Manipulation des données avec "data.table" (pour R)

2025-01-17 (Tag:BG9uMlyE5Ko)

Présentation et exploration des fonctionnalités du package « data.table » pour R, particulièrement performant pour la manipulation et le traitement des data frame. Mesure des durées d’exécution dans différentes configurations où l’on doit manier une base avec 9.796.862 observations et 42 descripteurs. Comparaisons avec le package « datatable » pour Python, qui s’inspire fortement de celui de R dixit la documentation. En définitive, les deux packages sont globalement équivalents, avec des spécificités propres à chacun selon la nature de l’opération.

Lien vidéo: https://www.youtube.com/watch?v=BG9uMlyE5Ko

Notebook + Fichier YAML : Programme - Notebook - Données

Manipulation des données avec "datatable" (Python)

2025-01-14 (Tag:-XpRV3QyYt8)

Description des fonctionnalités du package « datatable » pour Python. Il est inspiré du package « data.table » pour R. Il a pour particularité d’être performant sur les très grandes bases de données, notamment en parallélisant les traitements, exploitant ainsi, au moins, les capacités multicœurs de nos ordinateurs. Petite difficulté quand-même, « datatable » adopte une syntaxe assez spécifique, un peu déroutante peut-être pour les habitués de la référence « pandas ». Mais la documentation en ligne est très bien faite, avec notamment un tableau faisant le parallèle entre les deux outils. Le passage de l'un à l'autre est facilité. Notre expérimentation sur une base de 9.796.862 observations et 42 descripteurs montre que « datatable » surpasse « pandas » en rapidité de traitements. Il se montre compétitif par rapport au package « polars » qui excelle également dans la manipulation des données tabulaires.

Lien vidéo: https://www.youtube.com/watch?v=-XpRV3QyYt8

Notebook + Fichier YAML : Programme - Notebook - Données

DuckDB + Pandas - Combinaison gagnante

2025-01-13 (Tag:PUTqWDxvJ6k)

Description de DuckDB, un système de gestion de bases de données orientées colonnes, adapté pour le traitement analytique. Nous mettons l’accent sur son interfaçage avec Python, avec la possibilité de définir et exécuter des requêtes SQL sur des data frame Pandas, monotables et multitables via des jointures. A noter la facilité d’utilisation de DuckDB qui ne nécessite pas d’installation d’un serveur. Un environnement Python avec l’intégration du package dédié suffit pour monter une application. Enfin, non traité dans cette vidéo, mais souligné par de nombreuses références, DuckDB se révèle très performant pour l’appréhension des très grandes bases de données.

Lien vidéo: https://www.youtube.com/watch?v=PUTqWDxvJ6k

Notebook + Fichier YAML : Programme - Notebook - Données

Pandas vs. Polars - Performances comparées (Python)

2025-01-12 (Tag:R8T58O97z-Y)

Description de la librairie « Polars » pour Python. Elle se présente comme une alternative plus intuitive et largement plus efficace que « Pandas » pour la manipulation des data frame (données tabulaires). Comparaison des durées de traitements pour un dataset comprenant 9.796.862 observations et 42 variables (la base du challenge KDD CUP 1999, qui a été dupliquée), avec différentes opérations : chargement du fichier, filtrage, moyennes, moyennes conditionnelles, tri, comptage des valeurs. Pour la majorité des tâches, notamment grâce à sa capacité à paralléliser les opérations, la différence entre CPU Time et Wall Time est édifiante, « Polars » s’est montrée nettement plus performante.

Lien vidéo: https://www.youtube.com/watch?v=R8T58O97z-Y

Notebook + Fichier YAML : Programme - Notebook

Dataset : KDDCUP-99

Estimation et test statistiques

2025-01-11 (Tag:JBz4vJYrEre)

Un support de cours très succinct sur l’estimation (ponctuelle et par intervalle) et les tests d’hypothèses statistiques. Utilisé pour une remise à niveau en statistique inférentielle. Le document sert avant tout de repère pour la réalisation d’exercices illustratifs sous Excel, R et SAS.

Slides : Estimation et test statistiquesParallélisation des traitements avec Joblib (Python)

2024-12-30 (Tag:gQYp_CYCGVM)

Exploration des fonctionnalités de la librairie « Joblib » en matière de parallélisation des traitements. Cas d’étude avec l’implémentation de la stratégie OneVsRestClassifier pour la régression logistique multiclasse, l’algorithme sous-jacent est une régression logistique binaire basée sur un « fisher scoring ». Comparaison des durées d’exécution, (1) sans et avec la parallélisation, (2) entre deux technologies de parallélisation (processus vs. threads). Pour (1), bien que l’introduction du traitement parallèle soit significative, elle ne permet pas de réduire la durée proportionnellement au nombre de ressources demandées ; pour (2), les approches concurrentes (processus vs. threads) sont équivalentes, tout du moins pour le problème étudié.

Lien vidéo: https://www.youtube.com/watch?v=gQYp_CYCGVM

Sources : Programme - Notebook

Parallélisation Numba pour OneVsRestClassifier (Python)

2024-12-29 (Tag:OtQFfZE8Qa0)

Exploration des fonctionnalités de la librairie « Numba » (Python) pour le traitement parallèle en machine learning. Cas d’étude avec l’implémentation de la stratégie OneVsRestClassifier pour le classement multiclasse. La méthode sous-jacente est une régression logistique binaire avec l’algorithme Fisher Scoring, lui-même développé « from scratch » et « compilé » avec Numba. Mesure de la réduction du temps de traitement lors du passage à la parallélisation des calculs. Comparaison avec la classe OneVsRestClassifier de « scikit-learn » qui implémente également la parallélisation des traitements (via le paramètre n_jobs) à l’aide d’une autre technologie.

Lien vidéo: https://www.youtube.com/watch?v=OtQFfZE8Qa0

Sources : Programme - Notebook

Python rapide avec Taichi (vs. Numba)

2024-12-27 (Tag:4Z8156o6ZJ4)

Présentation de « Taichi », un package dédié à la haute performance pour la programmation Python, avec plusieurs fonctionnalités, dont la compilation à la volée (JIT – Just in Time Compiler) du code en instructions machines, ainsi que la parallélisation des calculs, etc. Dixit la documentation, la rapidité d’exécution peut surpasser celle de langages tels que le C++. Dans notre expérimentation où nous implémentons une recherche d’un minimum d’un vecteur « Numpy » en temps quadratique, les gains sont réellement spectaculaires par rapport au CPython (l’implémentation de référence en byte-code, à ne pas confondre avec Cython). Ils ne se démarquent pas en revanche par rapport aux packages équivalents tels que « Numba ». Enfin, l’adaptation du code Python à « Taichi » nécessite des contorsions qui peuvent se révéler contraignantes.

Lien vidéo: https://www.youtube.com/watch?v=4Z8156o6ZJ4

Sources : Programme - Notebook

Vectorisation des calculs – Numpy, Numba, Xarray (Python)

2024-12-26 (Tag:gcsu2sPUriU)

Principe de la vectorisation des traitements sur des grandes structures de vecteurs et matrices « numpy ». Itérations sur les valeurs avec les boucles. Accélération des calculs à l’aide du mécanisme de vectorisation. Exploitation de la « compilation » Numba de la fonction appliquée aux scalaires, avec les directives @njit et @vectorize. Utilisation de la fonctions dédiée de « xarray », plus efficace que vectorize() de « numpy ».

Lien vidéo: https://www.youtube.com/watch?v=gcsu2sPUriU

Sources : Programme - Notebook

Intégration de code C dans Python avec Cython

2024-12-23 (Tag:D__sO3x0FzQ)

Description et mise en œuvre de Cython, une extension du langage Python qui permet d’intégrer et d’interagir avec du code C dans un projet Python. Deux modes sont proposés : Pure Python, où le code reste compatible avec Python natif ; Cython où nous nous rapprochons davantage du langage C. L’installation d’un compilateur C/C++ est nécessaire. Dans ce tutoriel, je montre l’utilisation du dispositif dans un notebook, sans qu’il soit nécessaire de créer des fichiers additionnels. Les gains en temps de traitement sont spectaculaires dans le tri d’un vecteur Numpy avec des modifications mineures du code Python originel (en introduisant les déclarations de types simplement). Il est également possible d’améliorer les performances en ajustant les directives de compilation.

Lien vidéo: https://www.youtube.com/watch?v=D__sO3x0FzQ

Sources : Programme - Notebook

Python rapide avec Numba

2024-12-23 (Tag:BkJoHz0NGlE)

Présentation de Numba, un package qui réalise la compilation à la volée (JIT – Just in Time Compiler) du code Python en instructions machines. Les performances se rapprochent des langages tels que C ou Fortran. Le dispositif est très facile à mettre en œuvre, avec à la clé des gains en temps d’exécution réellement spectaculaires. Je montre cela dans un exemple de tri à bulles d’un vecteur de valeurs flottantes Numpy. Je montre également qu’il est possible de gagner encore davantage en exploitant à bon escient les possibilités de l’outil en termes de parallélisation des calculs.

Lien vidéo: https://www.youtube.com/watch?v=BkJoHz0NGlE

Sources : Programme - Notebook

Intégration de code C++ dans un projet R avec Rcpp

2024-12-09 (Tag:GEYIGcv1_dY)

Détection des goulots d’étranglement (en temps d’exécution) dans un programme R avec un profiler. Différentes pistes pour dépasser les écueils, en particulier la possibilité de réécrire en C++ les portions de code concernées. Utilisation de la librairie « Rcpp ». Installation du compilateur C++ via « RTools ». Configuration et écriture du fichier « .cpp ». Compilation, importation et utilisation dans R de la fonction compilée. Comparaison du temps traitement entre du code en R (« compilé » à la volée en Byte Code depuis R 3.4) et du code compilé C++ dans une implémentation du tri à bulles.

Lien vidéo: https://www.youtube.com/watch?v=GEYIGcv1_dY

Sources : Prog. et données

Combiner R et Python via Reticulate

2024-12-09 (Tag:nHC_Jptv3PY)

Pouvoir faire appel à du code Python dans un notebook R (.rmd). Installation et configuration préalable des outils. Accès à des objets R dans du code R, et inversement. Exemple de projet d’analyse prédictive où (1) sous R, les individus, décrits par des variables mixtes, sont projetés dans un espace factoriel via l’analyse factorielle des données mixtes du package « FactoMineR » ; (2) sous Python, modélisation de la variable cible à partir de la description factorielle via le package « Scikit-Learn ». Nous constatons que les échanges entre les 2 environnements (R et Python) sont fluides. Leur association élargit significativement nos capacités d’analyse.

Lien vidéo: https://www.youtube.com/watch?v=nHC_Jptv3PY

Sources : Prog. et données

Few-shot classification en NLP (spaCy / classy-classification)

2024-12-03 (Tag:799IlpTsCBs)

Catégorisation de textes à partir d’un modèle pré-entraîné peaufiné à l’aide de quelques (très peu) documents étiquetés. Utilisation du package « classy-classification » qui permet de compléter un pipeline de départ « spaCy ». Quelques éléments sur l’installation (difficile) du package, solution de repli avec Google Colab. Evaluation des performances sur la base IMDB de commentaires de films. Alternative avec le package « spacy-setfit ».

Lien vidéo: https://www.youtube.com/watch?v=799IlpTsCBs

Sources : Prog. et données

Image to text et traduction (Hugging Face / Transformers)

2024-12-03 (Tag:r9evaTAiAj0)

Combinaisons de pipelines Transformers (PyTorch, deep learning) basés sur des modèles pré-entraînés disponibles sur Hugging Face : un parseur d’image qui produit une description textuelle en anglais ; un traducteur qui traduit du texte de l’anglais vers le français. Les modèles pré-entraînés sont respectivement « ydshieh/vit-gpt2-coco-en » et « google-t5/t5-base ». Un regard rapide sur la liste des tâches couvertes par les pipelines Transformers dans les différents domaines : audio, computer vision, natural language processing (NLP), multimodal.

Lien vidéo: https://www.youtube.com/watch?v=r9evaTAiAj0

Sources : Prog. et données

Sentiment Analysis en NLP (Hugging Face / Transformers)

2024-12-02 (Tag:OLIDORb2v0U)

Analyse de sentiments en traitement des données textuelles via les modèles pré-entraînés accessibles sur Hugging Face. Utilisation du package « transformers » pour Python. Configuration de l’environnement. Utilisation de « PyTorch » comme moteur « deep learning » sous-jacent à la librairie. Quelques exemples d’usage avec parfois des résultats qui interrogent. Evaluation plus étendue sur la base IMDB (polarité des commentaires).

Lien vidéo: https://www.youtube.com/watch?v=Seqxhwv7I6U

Sources : Prog. et données

Zero-shot classification en NLP (Hugging Face / Transformers)

2024-12-02 (Tag:OLIDORb2v0U)

Principe du "Zero-Shot classification" en NLP (natural language processing, traitement statistique des données textuelles). Utilisation des modèles pré-entraînés pour le classement de documents dans un domaine spécifique. Modèle récupéré sur Hugging Face, dans notre cas "roberta-large-mnli". Installation des outils, en particulier du package "Transformers" et du moteur sous-jacent "PyTorch" (Python). Quelques exemples d'utilisation, avec la possibilité de contextualisation du classement. Evaluation du dispositif pour la catégorisation des commentaires de films (base IMDB). Réflexion sur le choix crucial du nom des classes.

Lien vidéo: https://www.youtube.com/watch?v=OLIDORb2v0U

Sources : Prog. et données

Deep Learning sous R avec le package torch

2024-11-18 (Tag:lx9mtZBdXow)

Implémentation d'un algorithme de deep learning (un perceptron multicouche) sous R à l'aide de la libraire « torch », basé sur « PyTorch ». Préparation des données, définition de la structure du réseau via une classe, paramétrage de la fonction de perte et de l'algorithme d'optimisation, entraînement du modèle, évaluation sur un échantillon test. Particularité de la vidéo : mise en parallèle sur le même problème (dataset, modèle) du code pour Python (PyTorch) avec le code pour le langage R ; les similitudes sont très fortes, sans que cela ne soit une surprise si l'on considère que « torch » est en réalité une interface pour PyTorch.

Lien vidéo: https://www.youtube.com/watch?v=lx9mtZBdXow

Sources : Prog. et données

R et Python - Performances comparées

2024-11-09 (Tag:FZqsL13wzPM)

Comparaison des performances des technologies sous-jacentes à R et Python. Le principe du JIT (just-in-time, compilation à la volée) qui génère du byte-code dans les deux cas. Mesures de performances dans l’implémentation d’un tri à bulles, où sont mis à l’épreuve principalement : l’accès aux valeurs d’un vecteur (lecture, écriture), la réalisation de boucles for imbriquées, la gestion des branchements conditionnels. Conclusion : les deux technologies se valent, pour ce qui est des versions évaluées tout du moins (R 4.4.1 vs. Python 3.12.4).

Lien vidéo: https://www.youtube.com/watch?v=FZqsL13wzPM

Sources : Prog. et données

Knime Interactive R Statistics Integration

2024-10-30 (Tag:GfFWq36GJf8)

Possibilité d’exécuter du code R au sein d’un workflow Knime à l’aide des composants R Scripting. Installation de l’extension « Interactive R Statistics » dans Knime. Configuration de l’outil avec désignation de l’interpréteur (moteur) R à utiliser. La question des packages R spécifiques que l’on souhaite intégrer dans nos workflows. La circulation des informations d’un composant à l’autre avec le mécanisme des ports en entrée et en sortie des composants (tables de données, worskpace de R). Pour illustrer le propos, mise en œuvre d’un tandem clustering enchaînant une projection des individus dans un espace factoriel et une classification (clustering) sur facteurs. Une des originalités ici est de choisir à bon escient les packages R (psych, fdm2id) permettant de traiter simplement et de manière lisible les individus supplémentaires.

Lien vidéo: https://www.youtube.com/watch?v=GfFWq36GJf8

Sources : Notebook et données

Extension Python pour Knime

2024-10-17 (Tag:5mFnx-umn_c)

Possibilité d'exécuter du code Python au sein d'un workflow Knime avec le composant Python Script. Installation du package Python pour Knime. Identification et/ou choix – à travers les environnements conda – des versions de Python et des packages de data science. Configuration par défaut du composant Python Script. Circulation des informations via le mécanisme des ports en entrée et sortie, pour les données (table) ou pour les modèles de machine learning (objets picklés). Mise en œuvre d'un schéma classique d'apprentissage/test en classification supervisée avec la régression logistique de la librairie scikit-learn. Quelques éléments de réflexion sur les sophistications possibles à travers le mécanisme des pipeline ou, plus prosaïquement, en s'appuyant sur de la programmation ad hoc en Python.

Lien vidéo: https://www.youtube.com/watch?v=5mFnx-umn_c

Sources : Notebook et données

Auto-encodeur avec PyTorch (Python)

2024-10-09 (Tag:70HFz9ooiI0)

Deep Learning - Machine learning. Définition, paramétrage, instanciation et entraînement des auto-encodeurs (autoencoders) avec PyTorch (Python). Retour rapide sur les auto-encodeurs, le principe de l'embedding, une représentation intermédiaire et une réduction de dimension qui a pour objectif de capter l'essence des informations portées par les données. Projection des individus dans l'espace intermédiaire. Reconstitution des données initiales. Fonction de coût, algorithme d'optimisation. Quelques applications : traitement des variables et des individus supplémentaires ; utilisation d'un auto-encodeur pour identifier les atypismes dans les données.

Lien vidéo: https://www.youtube.com/watch?v=70HFz9ooiI0

Sources : Notebook et données

Transfer Learning avec PyTorch (torchvision / Python)

2024-05-31 (Tag:HnKn1hi7ImyeMSxoqfU)

Deep Learning, réseaux de neurones convolutifs. Principe du transfer learning en computer vision. Comment construire un modèle hybride en appariant un modèle pré-entraîné sur des grands corpus (VGG19 sur ImageNet) avec un classifieur ad hoc pour un classement binaire (les fameux chats et chiens). Gap des performances entre un modèle ad hoc et le modèle hybride. Parallèle avec les embeddings en NLP (natural language processing).

Lien vidéo: https://www.youtube.com/watch?v=moUkAJLvte8

Sources : Notebook et données

Modèles pré-entraînés pour le classement d’images (PyTorch / Python)

2024-05-29 (Tag:MRc4lZ8qpOMLXzvfnbJ)

Mise en oeuvre de modèles de deep learning pré-entraînés sur des grands corpus étiquetés (ImageNet en l’occurrence) pour le classement d’images supplémentaires. Utilisation des librairies PyTorch / Torchvision pour Python. Etude du fonctionnement en particulier des classifieurs ResNet-50 et VGG-19. Principales étapes du processus : inspection de l’image, instanciation du modèle (avec pour la première utilisation, le chargement en ligne de ses poids synaptiques, stockés dans un dossier cache de la machine locale), la transformation de l’image pour qu’elle soit compatible avec le modèle, la prédiction avec le score d’appartenance.

Lien vidéo: https://www.youtube.com/watch?v=iMAVUMpbBqM

Sources : Notebook et données

Réseau de neurones convolutifs avec tensorflow / keras (Python)

2024-05-28 (Tag:HHqyzgcBZ4OQk5u7baq)

Définition et mise en oeuvre d’un réseau de neurones convolutifs (cnn / convnet – convolutional neural network) pour le classement d’images via le tandem de librairies de deep learning tensorflow / keras. Mise en parallèle des – exactement – mêmes traitements effectués à l’aide de PyTorch. Base exemple des figures « Pokémon ». Importation et préparation de la base étiquetée d’apprentissage. Architecture du CNN (convolutional neural network) : les couches de traitements convolutifs vs. les couches de perceptron. Choix de la fonction de perte (crossentropy) et de l’algorithme d’optimisation (adam). Organisation et exécution de l’entraînement du modèle. Application du modèle sur une base de test. Mesure des performances.

Lien vidéo: https://www.youtube.com/watch?v=lvkBPIb4p_0

Sources : Notebook et données

Réseau de neurones convolutifs avec PyTorch (torchvision / Python)

2024-05-27 (Tag:jeZ63S1USKmqwhJjZf9)

Définition et mise en oeuvre d’un réseau de neurones convolutifs (cnn / convnet – convolutional neural network) pour le classement d’images via la librairie de deep learning PyTorch. Utilisation de l’extension « torchvision ». Base exemple des figures « Pokémon ». Importation et préparation de la base étiquetée d’apprentissage avec, notamment, le typage en « tenseur » (tensor) des images. Architecture du CNN : les couches de traitements convolutifs vs. les couches de perceptron. Choix de la fonction de perte (crossentropyloss) et de l’algorithme d’optimisation (adam). Organisation et exécution de l’entraînement du modèle. Application du modèle sur une base de test. Mesure des performances.

Lien vidéo: https://www.youtube.com/watch?v=iCc_sAbuPj0

Sources : Notebook et données

Classement multiclasse avec PyTorch (Python)

2024-05-22 (Tag:baqtEtXHe2TMwUvQLUW)

Suite de la vidéo consacrée à la classification supervisée à l’aide des perceptrons simples et multicouches (réseaux de neurones), utilisation de la librairie PyTorch dédiée au machine learning / deep learning. Par rapport à classification binaire (cf. lien de la vidéo ci-dessous), plusieurs spécificités pour pouvoir traiter un problème multiclasse (variable cible catégorielle à plus [strictement] de 2 modalités) : nécessité d’encoder la variable cible catégorielle en matrice 0/1 via un codage disjonctif complet (OneHotEncoder) pour pouvoir utiliser le critère MSE ; utilisation d’une fonction de transfert adaptée (softmax) ; en prédiction, conversion de la matrice des probabilités d’affectation en vecteur de modalités. Traitement des données "iris".

Lien vidéo: https://www.youtube.com/watch?v=BV37oO-uTaU

Sources : Notebook et données

Classement binaire avec PyTorch (Python)

2024-05-22 (Tag:A5g98NGUHOydweoPOSt)

Classement ou classification supervisée binaire avec la librairie PyTorch (Python). Particularités de l’outil dans le cadre de la définition et de la mise en œuvre des perceptrons simples et multicouches (réseaux de neurones) : mettre les données sous la forme de tenseurs (tensor, des matrices et vecteurs optimisés pour les calculs de machine learning) ; définir l’architecture et le comportement du réseau sous la forme d’une classe ; écrire explicitement les différentes étapes de « fit » pour l’entraînement du modèle. PyTorch fait partie des librairies phares de deep learning à ce jour.

Lien vidéo: https://www.youtube.com/watch?v=ipzemUBDAqU

Sources : Notebook et données

Formulaire interactif dans un notebook (ipywigdets / Python)

2024-05-17 (Tag:g5rxxgstMDnZFTB9Sck)

Création de formulaire interactif dans un notebook Jupyter à l'aide du package « Ipywidgets » pour Python. Initialisation, disposition et paramétrage des objets visuels ; programmation des gestionnaires d'évènements. Plusieurs exemples de programmes très simples, mise en parallèle avec le fonctionnement d'une application console que l'on chercherait à faire exécuter au sein d'un notebook. Utilisation de VS Code.

Lien vidéo: https://www.youtube.com/watch?v=vhFReA8jPUA

Sources : Notebook et données

Clustering – Déploiement Web App (streamlit / Python)

2024-03-31 (Tag:98DO0qpqE9Q2yik17lY)

Déploiement d'un modèle de clustering (classification automatique, non-supervisée) sous la forme d'une Web App développée à l'aide de la technologie « streamlit » pour Python. Le « modèle » correspond en réalité à un processus encapsulé dans une structure Pipeline de « scikit-learn ». Il comprend un mécanisme d'imputation des données manquantes (SimpleImputer), la standardisation des données (StandardScaler) et la méthode K-Means (KMeans). Il est utilisable en déploiement c.-à-d. il peut s'appliquer en généralisation sur des individus supplémentaires sans qu'il soit nécessaire d'avoir accès aux données d'entraînement. Elaboration enfin d'une application streamlit permettant de saisir les caractéristiques d'un individu, d'obtenir son groupe d'affectation, la distance aux barycentres des groupes, de disposer d'indications sur le mécanisme d'affectation à travers les valeurs prises par les variables.

Lien vidéo: https://www.youtube.com/watch?v=wYW47OnxdWA

Sources : Notebook et données

Pipeline – FunctionTransformer (scikit-learn / Python)

2024-03-31 (Tag:CjjKEbDRNnV8AKgk9sF)

Utilisation de l'outil FunctionTransformer dans une phase de préparation de données, incorporée dans un Pipeline scikit-learn. La fonction de transformation peut être définie à la volée (fonction lambda) ou implémentée à part. Le plus important est d'être en cohérence avec le format des variables passées en paramètres. Sérialisation du workflow complet (préparation des données + modèle de machine learning [régression logistique ici]) à l'aide du package "dill" (le package "pickle" ne sait pas manipuler les fonctions lambda).

Lien vidéo: https://www.youtube.com/watch?v=buIQuxM_uro

Sources : Notebook et données

Pipeline – Paramétrage (scikit-learn / Python)

2024-03-29 (Tag:NSwdHhRFRrtsL8kK8NJ)

Pipeline sous Python dans le cadre de l'analyse conjointe (tandem clustering) mixant analyse factorielle et classification automatique (clustering). Accès aux étapes intermédiaires du pipeline avec une double finalité : (1) lecture des résultats ; (2) manipulation des paramètres des algorithmes pour pouvoir relancer les calculs sans avoir à réinstancier à chaque fois le pipeline dans sa globalité. Exemple avec une ACP (analyse en composantes principales) associée à un K-Means où l'objectif est de déterminer le nombre de facteurs à retenir pour une solution efficace. Nous nous plaçons dans un cadre particulier où les vraies classes d'appartenance sont connues, une mesure externe d'évaluation des partitions est utilisée (v-measure).

Lien vidéo: https://www.youtube.com/watch?v=bUMky9EFVLM

Sources : Notebook et données

Microsoft COPILOT... est mon ami

2024-03-29 (Tag:5BMprVboQr4)

Quelques expériences amusantes (?) avec Microsoft Copilot. Inspection des résultats et surtout des sources utilisées lors de requêtes relatives au machine learning (analyse discriminante prédictive, catégorisation de documents [NLP], identification de communautés dans les réseaux sociaux, clustering mixte). Avec, en filigrane, des questions (ou des remises en question) sur nos pratiques pédagogiques et l'intégration de ces outils d'IA générative dans nos dispositifs d'enseignement.

Lien vidéo: https://www.youtube.com/watch?v=5BMprVboQr4

Pipeline avec ColumnTransformer (scikit-learn / Python)

2024-03-27 (Tag:XyIUp1qLjRKMig8bXLE)

Implémentation de l'AFDM (analyse factorielle des données mixtes) à l'aide d'un "Pipeline" scikit-learn. Utilisation de l'outil "ColumnTransformer" pour effectuer les transformations de variables conditionnellement à leurs types (quantitatives [StandardScaler] et qualitatives [OneHotEncoder, Réduction par la racine de la fréquence]), les données étant ensuite présentées à un algorithme d'ACP (analyse en composantes principales). Elaboration d'une classe héritière de StandardScaler pour implémenter la réduction des indicatrices par la racine de la fréquence. Sauvegarde du "modèle" dans un fichier binaire à l'aide du package "dill". Chargement et application du modèle sur un individu supplémentaire. Comparaison de nos résultats avec ceux du package "scientisttools" qui fait référence en analyse de données sous Python.

Lien vidéo: https://www.youtube.com/watch?v=qy5qn_06UZA

Sources : Notebook et données

LibreOffice Calc - Filtres et Tableaux croisés dynamiques

2024-01-26 (Tag:RyPUZzMDu9c)

Manipulation des données sous le tableur LibreOffice Calc : AutoFiltre (filtre automatique), filtre standard, filtre spécial (filtres avancés, avec les zones de données, de critères et d'extraction), tableaux croisés dynamiques (TCD, champs de filtres et champs calculés).

Lien vidéo: https://www.youtube.com/watch?v=RyPUZzMDu9c

Sources : Données

Macros Python pour LibreOffice Calc (2) - Sélections simples et multiples

2023-12-29 (Tag:gl6Ygm9ksUQ)

Programmation de macros Python pour LibreOffice Calc, le tableur de la suite bureautique LibreOffice. Traitement des plages de cellules sélectionnées par l'utilisateur. Identification du type de sélection : une seule plage de cellules ou plusieurs plages non-contigües. Parcours des zones, parcours des cellules à l'intérieur d'une zone. Lecture, écriture et mise en forme des cellules.

Lien vidéo: https://www.youtube.com/watch?v=gl6Ygm9ksUQ

Sources : Prog. et Données

Fonctions personnalisées Python pour LibreOffice Calc

2023-12-28 (Tag:k2e2ADQBOiU)

Implémentation de fonctions dans des modules Python que l'on peut exploiter sous la forme de fonctions personnalisées dans une feuille de calcul du tableur Calc de la suite bureautique LibreOffice. Création et localisation du module Python dans le dossier "user". Elaboration d'une unité d'import Basic dans un classeur. Programmation en Basic de la fonction d'appel des fonctions Python.

Lien vidéo: https://www.youtube.com/watch?v=k2e2ADQBOiU

Sources : Prog. et Données

Macros Python pour LibreOffice Calc

2023-12-28 (Tag:d5Mga1TibJc)

Programmation de macros Python pour LibreOffice Calc via la librairie ScriptForge. Installations préalables, configuration de la machine pour que l’interpréteur Python soit visible de la suite bureautique, emplacement spécifique de nos modules Python pour LibreOffice. Ensuite, programmation des macros avec l’accès aux services via ScriptForge, notamment instanciation du service tableur et l’accès en lecture et écriture aux éléments de la feuille de calcul. Quelques exemples de macros, dont une – recueil des résultats de simulations répétées de lancer de pièces de monnaie – s’appuyant sur les capacités de calcul du tableur.

Lien vidéo: https://www.youtube.com/watch?v=d5Mga1TibJc

Sources : Prog. et Données

Requêtes SQL sur DataFrame Pandas (pandasql / Python)

2023-12-24 (Tag:5wpXzrG0KNA)

Utilisation de requêtes SQL pour accéder aux informations d'une base de données sous la forme de tables « DataFrame – Pandas » chargées en mémoire. Utilisation du package « pandasql ». Requêtes simples, requêtes avec jointures. Parallèle avec les fonctions natives du package « Pandas ». Quelques éléments de réflexion quant à l'opportunité de cette solution pour la manipulation des bases de données (volumétrie, performances).

Lien vidéo: https://www.youtube.com/watch?v=5wpXzrG0KNA

Sources : Prog. et Données

Dockerisation (Base de données [SQLite] + Web App Python [gradio])

2023-12-23 (Tag:-GgG1Wb2F64)

Création d'une image docker contenant une base de données (multi-tables) et une web app Python (basée sur « gradio » pour cette dernière, mais ça aurait pu être Streamlit, Shiny, Dash, Bokeh, etc.). L'enjeu du choix technologique pour la base de données. La contrainte d'installation et de configuration si utilisation d'un serveur de SGBD traditionnel (ex. MySQL, PostgreSQL, etc.). L'intérêt de s'appuyer sur SQLite qui intègre dans un simple fichier l'ensemble des tables. L'accès à la base sous Python passe par l'installation d'un package (pysqlite3 dans cette vidéo). La manipulation de données se fait via des requêtes SQL. La simplicité du dispositif permet de créer très facilement une image docker encapsulant l'ensemble des éléments du programme.

Lien vidéo: https://www.youtube.com/watch?v=-GgG1Wb2F64

Sources : Prog. et Données

NLP - Catégorisation de documents avec "fasttext" (Python)